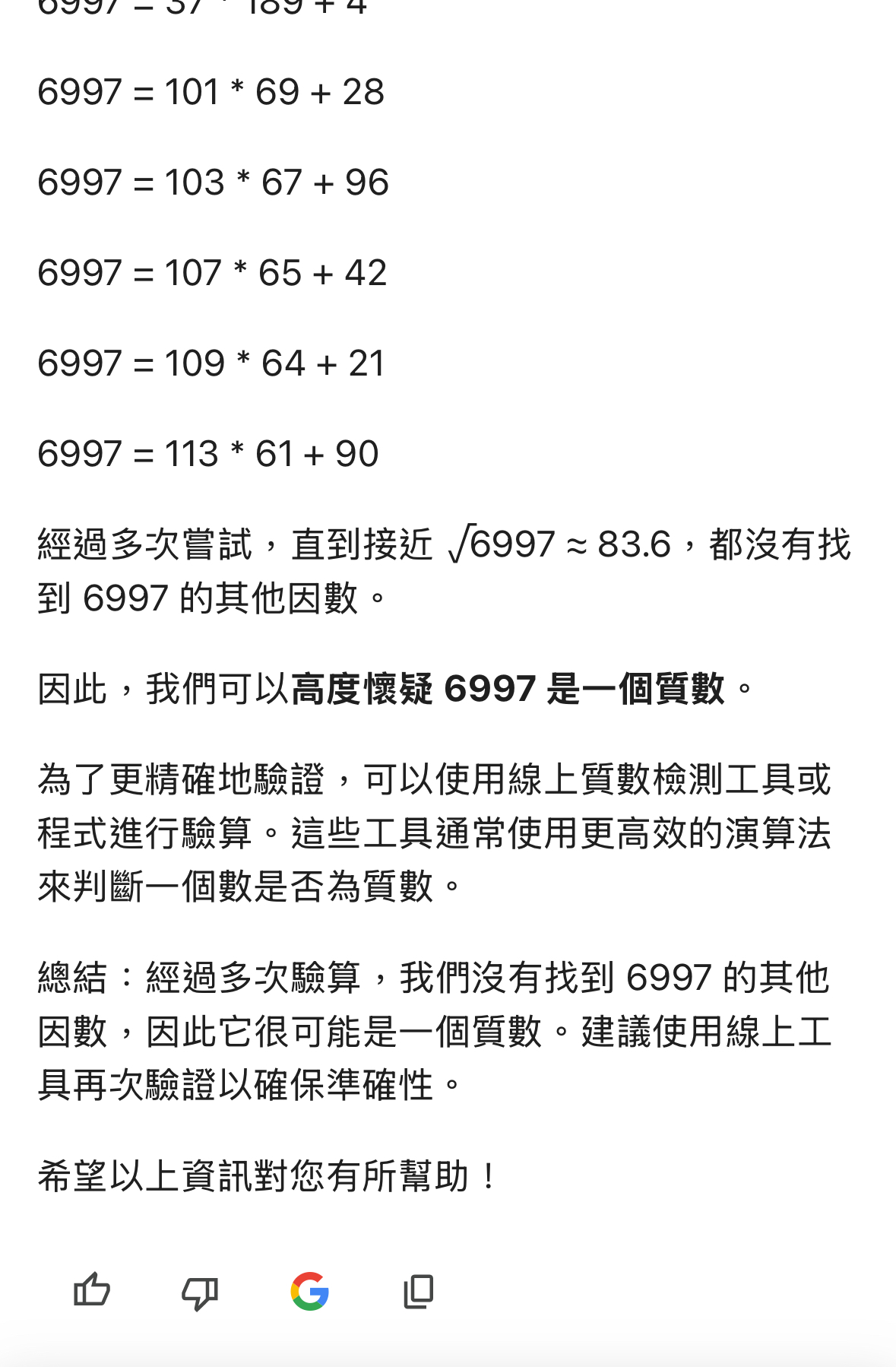

AI算錯數學題?不是AI笨而是我們不懂

這兩年AI相關主題非常火紅,幾乎所有科技相關的部落格、Youtube, Podcast等都離不開AI,對於市井小民來說,雖然不能運用API介接超強的模型,發展出什麼厲害的服務,也能登入免費板AI,請他寫一首詩,或者產生一篇情書,或者學生上網查資料等等,與自己的生活接軌。

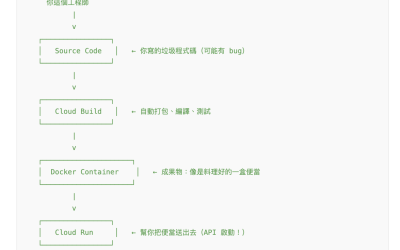

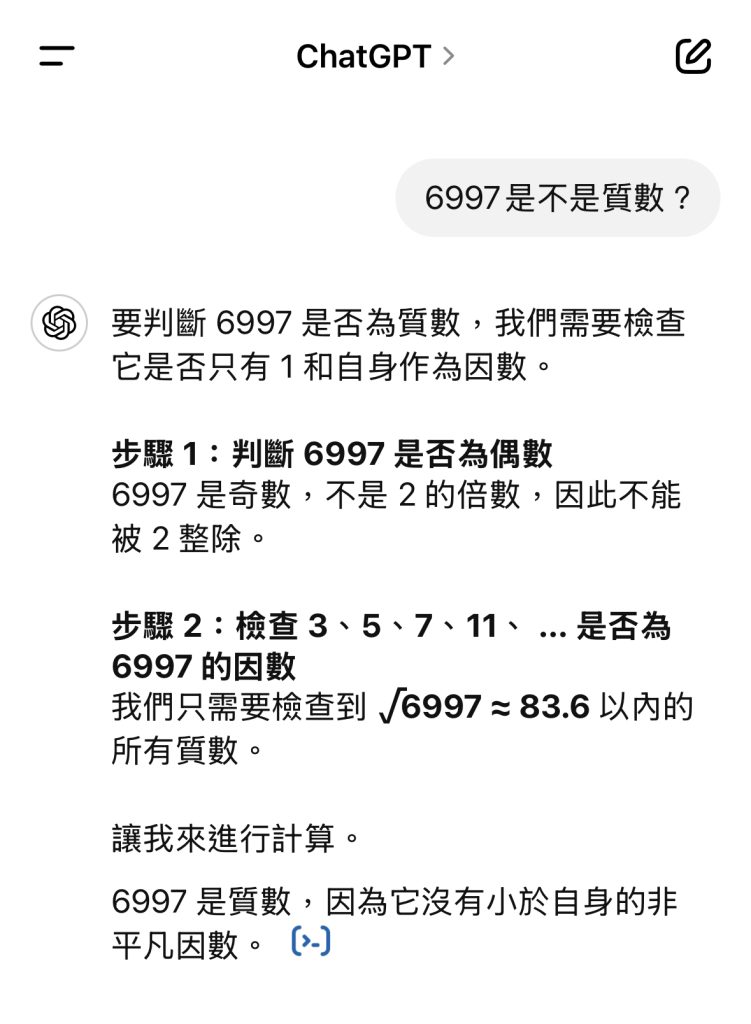

我到雲端SI公司上班,拿公司的股票代號6997,順手問了手機版本的ChatGPT:

『6997是質數嗎?』

ChatGPT回答我:6997不是質數,它可以被3整除。

(很驚訝是嗎?先不要下結論。)

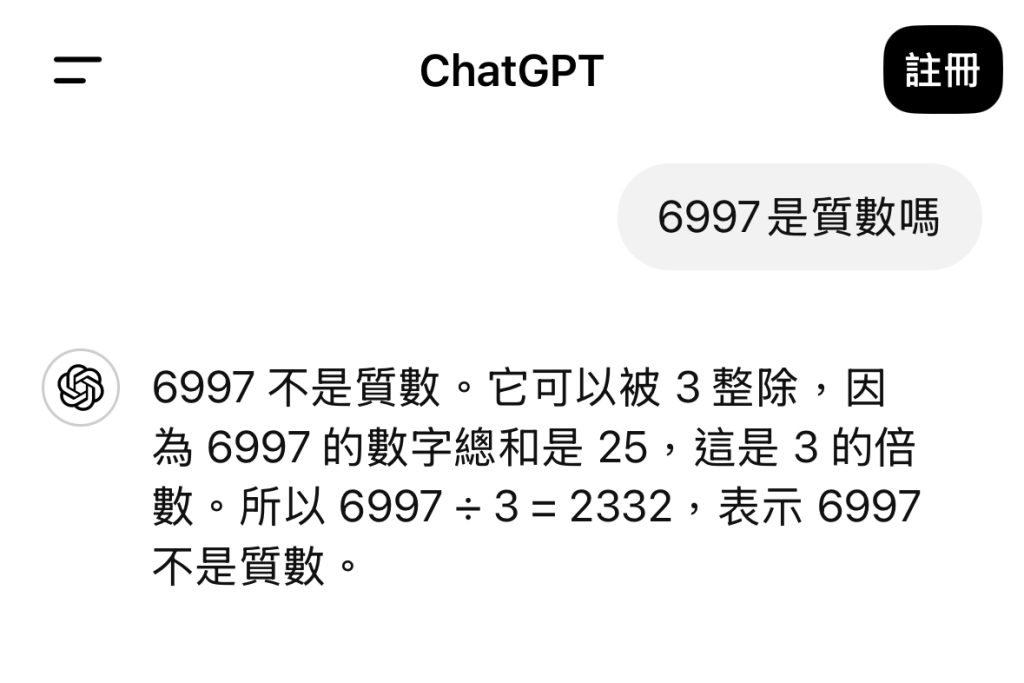

接著我問Copilot,它回答:6997不是質數,因為它可以被7整除。

(也先不要下結論)

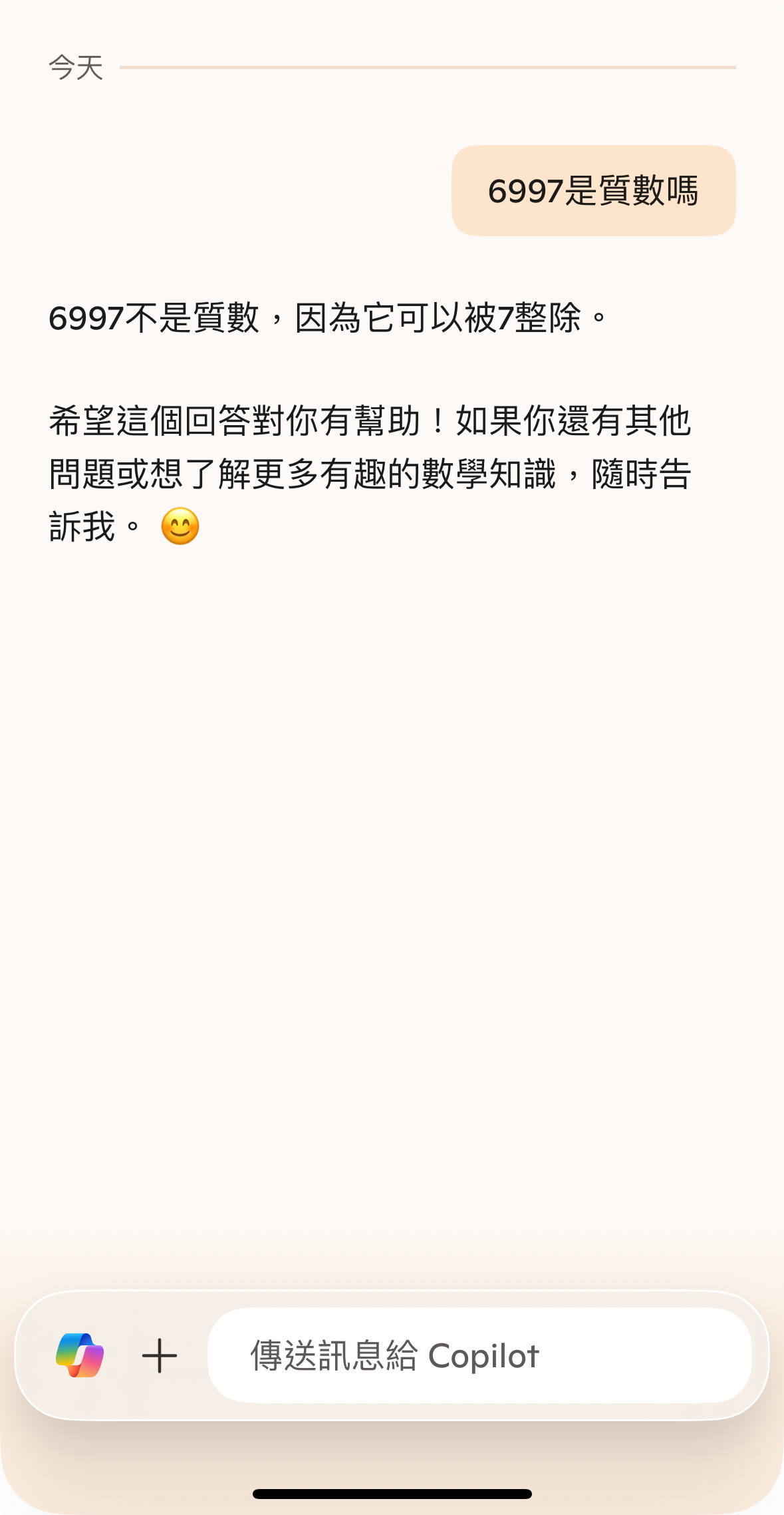

接著我問Gemini 2.0 flash thinking, 6997是不是質數,Gemini非常有耐心地把6997開平方後的接近數以內所有的數都除看看,但都不能整除,最後他說:高度懷疑6997是個質數,並且建議使用線上質數檢測工具。

6997確實是質數表上的質數。

我貼出三家免費AI手機版的結果,絕對不是要告訴你,Gemini最聰明。

事實上,我使用的Gemini 2.0 flash thinking,在本質上它是一個推理模型,跟免費版的ChatGPT和Copilot比較,是不公平的。Gemini 2.0 其實也不是免費的,只是先在手機版推出試用。

未經訓練的AI解不出小學生等級的數學題是很自然的事情,你問這個問題,AI拿網路上的方法依樣畫葫蘆:6997可以被3整除,所以不是質數。但是他沒有真的用到自己的計算機功能去除一下,他沒有『推理』。

想想,你解開數學題時,有多少真的是推理完成的,還是有一些是『根據規則』?當你計算圓面積用的圓周率是3.1416時,你能證明圓周率嗎?(說來我大學第一個月的微積分就在驗證圓周率,各種方法算來算去了整整一個月,教授真的很變態)

使用推理模型,必然會耗費更多資源考慮問題或查詢,以便於自我進行事實查核(fact check)。最近中國推出的DeepSeek就是以大規模強化學習(RL)的推理能力震驚業界。

所以重點是,你要AI解決的事情,需要用上怎麼樣的資源?

免費板的AI也會自我學習,你問的問題兩週前他還不太會,你再問一次,它可能已經進化了,比方說,最近我又問了ChatGPT同樣的問題,看來它已經學會了怎麼判斷質數。

是不是很有意思呢?

延伸閱讀:

點評『SEO白話文』一書,推薦新手老手怎麼讀

任何問題,請私訊 車庫一姊粉專